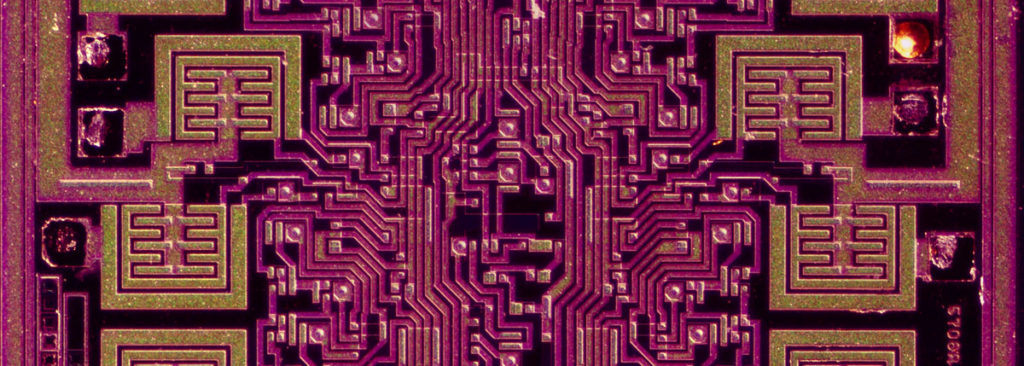

Città di transistor, vicoli nascosti dietro fila di capacitori, giri l’angolo e sei in una piazzetta circondata da consendatori. Li abbiamo spesso immaginati come metropoli di silicio in miniatura in cui gli elettroni, laboriosi, scorrono alla velocità della luce. Un microchip, per definizione, è un circuito (integrato) che processa o elabora segnali elettrici dati in input e restituisce un output. Un piccolo organismo pensante.

Alcuni microchip, sono qualcosa di più, perché hanno dato il via a straordinarie rivoluzioni. Vediamo alcuni dei microchip più famosi e significativi e com’è nata una delle rivoluzioni del nostro tempo.

Nel luglio 1958 l’ingegnere Jack Kilby lavora da poco più di un mese in una piccola ma innovativa azienda texana, la Texas Instruments. Quattro anni prima aveva lanciato una delle prime radioline tascabili a transistor, che le aveva garantito un enorme successo commerciale. Tutti i nuovi sforzi, però, sono rivolti verso il silicio. Costruire un intero circuito su un cristallo che resiste bene al calore, che costa poco realizzare sembra un’ottima idea. La storia dei piccoli circuiti integrati inizia d’estate: sono tutti in vacanza, in azienda. Il neo assunto ingegnere americano ha molto tempo per pensare girando per le sale svuotate dalle ferie. «Come nuovo impiegato, non andai in ferie e, da solo, cominciai a pensare che tutte le parti di un circuito, non solo i transistor, potevano essere scolpite nel silicio, miniaturizzate.» Nel 1959 dalle fabbriche della Texas Instruments viene fuori il primo circuito integrato, grande quando la punta di una penna.

Contemporaneamente un altro uomo aveva fondato, due anni prima in California, la Fairchild Semiconductor.

Robert Noyce, con i suoi sette colleghi, ragiona anch’egli che un circuito può essere integrato su un singolo chip. Noyce, rispetto a Kilby, lavora maggiormente su come connettere efficacemente le varie parti. In primavera, l’azienda deposita un brevetto riguardante un circuito unitario.

Inizia una stupenda rivoluzione tecnologica, quella dei microchip.

I due non si conosceranno per anni. Persone molto diverse, timido ed impacciato il primo, atletico, bello, spigliato il secondo. Insieme, ma non insieme, hanno inventato i microchip moderni. Robert Noyce, fonderà nel 1968 la Intel, e darà il nome a quella che oggi conosciamo come Silicon Valley, tanto da essere soprannominato “The Mayor of Silicon Valley [Il sindaco della Silicon Valley]”.

Nel 2000, Jack Kilby, vince il premio Nobel per la fisica e menziona, nel suo discorso, proprio Robert Noyce, morto nel 1990. «Se fosse ancora in vita, non ho dubbi che avremmo condiviso questo premio.» Inventerà poi la calcolatrice tascabile e la stampante termica.

Era l’estate del 1970 e il progettista di microchip Hans Camenzind avrebbe potuto dirvi una cosa o due riguardo i ristoranti cinesi: il suo ufficio a pianterreno era incastrato fra due di essi, a Sunnyvale, California. Camenzind lavorava come consulente alla Signetics. L’economia era in sofferenza, e il suo stipendio di 15mila dollari all’anno non bastava per sua moglie e i suoi quattro figli. Aveva davvero necessità di inventare qualcosa di buono.

E lo fece. Uno dei più famosi chip di tutti i tempi. Il 555 è un semplice chip che può funzionare da timer o oscillatore. Diventerà un best seller tra i chip analogici e finirà in quasi tutti gli elettrodomestici da cucina, giocattoli, astronavi e migliaia di altri apparecchi.

L’idea del 555 venne fuori mentre lavorava ad un altro sistema, che semplificato poteva lavorare come un semplice timer. Lo fai partire e lui gira per un dato periodo. Semplice. Ai tempi non c’era niente di simile in giro. Dopo i primi rifiuti da parte dell’azienda e un’anno speso nei test «Fatti a mano, senza il computer» il chip è pronto: 23 transistor, 16 resistori, 2 diodi. Appena lanciato, nel 1971 fu sensazionale. Quattro anni dopo, la Philips acquisterà l’azienda, dichiarando che ne sono stati venduti miliardi. È ancora molto usato oggi, sia per progetti importanti che per emulare i led di Kitt in Supercar.

«E stavo per non farlo.» ricorda Camenzind, che a 75 anni progetta ancora chip, da qualche parte vicino un ristorante Cinese.

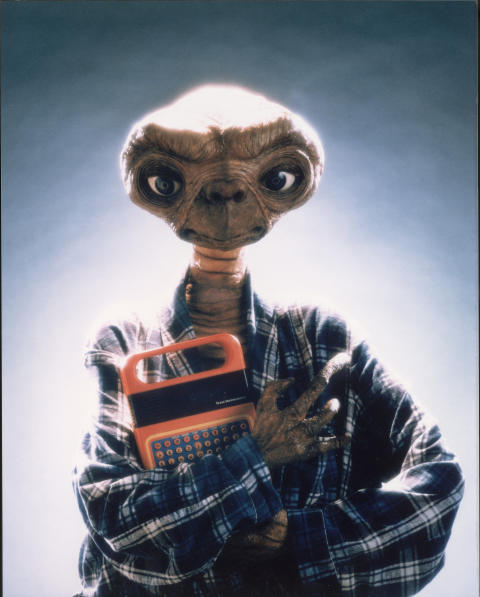

Senza questo chip, E.T. l’extraterrestre non avrebbe mai potuto telefono casa. Questo perché il TMC0281, il primo chip con un sintetizzatore vocale, è stato il cuore del Grillo Parlante di Clementoni (Speak&Spell di Texas Intruments). Nella pellicola di Spielberg, il piccolo E.T. lo usa per costruire il suo comunicatore interplanetario. (assieme ad una gruccia, una lattina e una sega circolare).

Il chip crea la voce usando una tecnica chiamata codifica predittiva lineare. Il suono viene fuori come una combinazione di modulazione e suono, proprio come la voce umana. Qualcuno definì la cosa impossibile da realizzare come un integrato. Gene A. Frantz, uno degli ingegneri, fra questi. Usato per decenni, la sua produzione è terminata nel 2007. Se però dovete telefonare ad un posto davvero lontano, troverete sicuramente un Grillo Parlante su eBay.

Quando quel geek lo inserì in un computer sperimentale e questo si avviò regolarmente, l’universo ebbe un sussulto. Quel geek era Steve Wozniak, il computer era l’Apple I, e il chip era il 6502, un microprocessore a 8 bit creato da un’azienda chiamata MOS Technology. Quel chip divenne il cervello dei primi computer, come l’Apple II, il Commodore PET e delle prime console di Nintendo e Atari.

Chuck Peddle, uno dei creatori del chip, ricorda quando il 6502 fu presentato ad una fiera nel ’75. «Avevamo due barattoli di vetro pieni di chip e mia moglie, seduta allo stand, li vendeva. Li vendemmo tutti.» Il motivo: il 6502 non era solo più veloce dei suoi concorrenti, ma anche più economico. Venduto a 25 dollari contro i quasi 200 dell’Intel 8080 e del Motorola 6800.

Il passo in avanti, secondo Bill Mensch, che ha creato il 6502 con Peddle, era la combinazione di semplicità e processo produttivo che fruttava (in produzione) 10 volte in più chip funzionanti rispetto alla concorrenza. «Il 6502 ha fatto calare drasticamente il prezzo dei processori, favorendo la rivoluzione del personal computer.» Alcuni sistemi usano ancora questo chip. Uno degli usi più famosi, comunque, rimane quello del cervello di Bender in Futurama, come rivelato in un episodio del 1999.

Nei primi anni 80, Acorn Computers era una piccola compagnia con un grande prodotto. L’azienda, con sede a Cambridge, aveva venduto 1 milione e mezzo di computer BBC Micro. Giunti al momento di progettare un nuovo modello, gli ignegneri pensarono bene di creare il proprio processore a 32bit. Chiamarono il frutto dei loro sforzi Acorn RISC Machine, per tutti ARM. I problemi furono non pochi, per la piccola azienda inglese «Il team era così piccolo che ogni scelta era in favore della semplificazione. Altrimenti non lo avremmo mai finito!» disse Steve Furber, oggi docente alla University of Manchester. Tutta questa semplicità ha fatto la differenza: l’ARM era piccolo, consumava poco ed era facile da programmare. Sophie Wilson, che ha progettato l’instruction set, ricorda il suo primo test. Diede il comando “PRINT PI” e il sistema beccò la risposta. Nel 1990 la divisione ARM si distaccò, diventando leader dei processori cosiddetti embedded a 32bit. Quello che non sapevano è che l’architettura ARM sarebbe stata l’architettura scelta per lo sviluppo degli smartphone: a partire dall’iPhone tutti lo usano: ad oggi il 90% degli smartphone, il 10% dei computer, il 35% delle TV per un totale di 50 miliardi di chip prodotti.

Lanciata nel 1991, la fotocamera Kodak DCS 100 costava 13mila dollari e richiedeva una unità storage esterna dal peso di 5kg, a forma di valigetta. L’elettronica era stata infilata nel corpo di una Nikon F3, incluso un pezzo di hardware davvero straordinario: un chip, grande quanto un’unghia, che poteva catturare le immagini ad 1.3megapixel, abbastanza per la stampa di una foto 10x15cm ad alta risoluzione. «Ai tempi, 1 megapixel era un numero magico» racconta Eric Stevens, il capo progetto. Il microchip, un charge-coupled device, diventò la base di tutti i futuri sensori CCD, dando il via alla rivoluzione digitale della fotografia.

Qual è stata la prima fotografia scattata con la KAF-1300? «Uhm, abbiamo semplicemente puntato il sensore verso una parete del laboratorio.»

Da un lato del tavolo, 1 kilogrammo e mezzo di materia grigia. Dall’altro, 480 processori in parallelo. Gli umani avevano finalmente perso contro i computer nel 1997, grazie al supercomputer da scacchi IBM Deep Blue 2 che aveva battuto il campione del mondo Garry Kasparov. Ogni processore del Deep Blue 2 era composto da 1,5 milioni di transistor, progettati come blocchi specializzati per giocare a scacchi. Tutti insieme, i processori potevano prevedere un numero esorbitante di prossime possibili mosse, 200 milioni al secondo. Questa forza bruta di calcolo, combinata al software diede la vittoria al computer nel 1997. Non dopo aver sonoramente perso, l’anno prima, 4-2 contro lo stesso campione russo su 6 game.

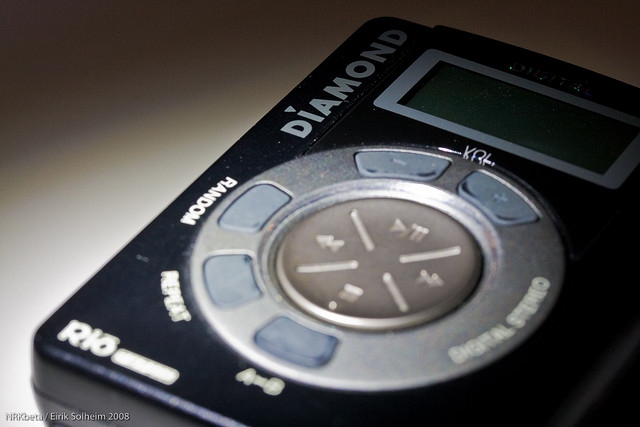

Prima dell’iPod, il lettore più famoso era il Diamond Rio PMP3000. Non so se lo ricordate. Lanciato nel 1998, il Rio divenne subito un best seller, ma l’hype svanì presto. Una cosa però, lo rendeva particolare. Il suo cuore era il chip MAS3507, un microchip RISC, che processava segnali digitali con delle istruzioni specifiche per la compressione e decompressione dell’audio. Sviluppato dalla Micronas, permetteva al Rio di suonare gli mp3 contenuti nella sua memoria flash (ai tempi capiente giusto abbastanza da competere con un CD). Aprì la strada, quindi, all’iPod. La possibilità di avere Thousands songs in your pocket la dobbiamo proprio a lui.

L’invenzione delle memoria flash assomiglia ad una saga, che comincia con la decisione di Fujio Masuoka, ignegnere Toshiba, di reinventare la memoria su semiconduttore. Fino a quel momento, l’unico modo di stoccare dati era quello di archiviarli su nastro magnetico, floppy, o uno dei nuovi (ma piccoli) hard disk. Molti aziende avevano cercato di creare memorie allo stato solito (come la EPROM/EEPROM), ma il costo-per-megabyte era enorme.

Masuoka non ci stava e creò, nel 1980, un team segreto di quattro ingegneri per lavorare su un chip di memoria che potesse ospitare una grande quantità di dati ad un prezzo accettabile. La strategia era semplice «Sapevamo che il costo del chip sarebbe sceso gradualmente con la riduzione della grandezza di fabbricazione dei chip.» Il team tirò fuori una soluzione molto elegante che, a differenza delle vecchie memorie, aveva un solo transistor (anziché due) per cella. Era veloce, tanto che decisero di dargli il nome di memoria flash. Potreste pensare che sia stato messo in produzione, che Toshiba abbia incassato miliardi, ma non fu così. Il boss di Masuoka gli disse di abbandonare il progetto.

Ovviamente non lo fece. Anzi, nel 1984 presentò, su carta, il suo progetto alla IEEE di San Francisco. Intel ne approfittò per cominciare lo sviluppo del proprio progetto memoria flash, basato su porte NOR anziché NAND. Nel 1988 introdusse il primo chip a 32Kb, subito adottato in centinaia di articoli di elettronica di consumo, automobili, impianti industriali.

Davanti a tutto questo la Toshiba, decise finalmente di mettere sul mercato l’invenzione di Masuoka, che garantiva grandi densità di archiviazione, seppur portando qualche difficoltà di produzione. Il successo venne nel 1989, quando finalmente le memorie arrivarono sul mercato. Come previsto da Mausoka, i prezzi cominciarono a scendere. Uno degli artefici della diffusione fu certamente la fotografia digitale nei tardi anni 90, ma oggi, quasi tutti i nostri gadget elettronici hanno a bordo una memoria flash. Senza dimenticare le chiavette USB.

Fujio Masuoka lascerà la Toshiba, garantendosi una parte del mercato multi-miliardario delle memorie flash.

Qual è il chip che ha portato Intel nella Fortune 500? Naturalmente l’8088, il processore a 16bit che la IBM scelse per la sua prima linea di personal computer, che avrebbe dominato il mercato. In pochi anni questo chip avrebbe gettato le basi per l’architettura x86, nonostante il suo nome finisca per 88. «Infatti, in sostanza, l’8088 era una versione modificata dell’8086, il primo vero CPU a 16 bit.» o come l’ignegnere Stephen Morse disse una volta «Una sua versione castrata.» Questo perché l’8088 processa i dati a 16bit ma il suo bus (il modo con cui comunica con l’esterno) è a 8bit.

I manager di Intel tennero il progetto 8088 segreto fino alla presentazione dell’8086, il fratello maggiore, per non generare ritardi dicendo “abbiamo anche una sua variante”. Solo dopo l’uscita dei primi 8086 Intel inviò la documentazione progettuale alla sua sede in Israele, dove due ingegneri, Rafi Retter e Dany Star, alterarono il chip per farlo diventare ad 8 bit.

La modifica è stata una delle migliori decisioni della storia dei computer. I 29mila transistor che muovono l’8088 richiedono meno (e meno costosi) chip di supporto e forniscono una piena retro-compatibilità con i vecchi sistemi a 8bit, creando, in sostanza, un ponte tra 8 e 16bit, come scrisse lo stesso Robert Noyce nel 1981.

Il primo PC ad usare l’8088, come accennato, è il Modello 5150 di IBM, con schermo bianco e nero, dal costo di 3000 dollari. Oggi praticamente tutti i PC del mondo usano processori derivati proprio dall’8088. Non male per un chip castrato.

La storia di Kevin Mitnick, l’hacker più famoso del mondo

La storia di Kevin Mitnick, l’hacker più famoso del mondo

La vita segreta degli studenti che minano Bitcoin

La vita segreta degli studenti che minano Bitcoin

I messaggi segreti fra Trump Jr e WikiLeaks

I messaggi segreti fra Trump Jr e WikiLeaks