Circa 6 anni fa, in un’intervista a The Guardian, Tim Berners-Lee, lanciò un avvertimento:

“Quanto più si entra, più si resta bloccati. Il vostro sito di social networking diventa una piattaforma centrale – un silo chiuso di contenuti, che non ti dà il pieno controllo sulle informazioni che ricevi in esso. Più si diffonde questo tipo di architettura, più il web diventa frammentato, e tanto meno possiamo goderci un unico spazio informativo universale.”

Oggi tuo zio ti ha raccontato un paio di notizie che ha letto su Facebook, lui un grillino convinto ma neanche tanto, ne ha letta una divertente su Renzi e una meno divertente sulle scie chimiche e i gravi problemi che provocano. Tu non hai letto nessuna delle due.

Più tardi sei su Facebook e ti stupisci di quanto la tua ex-compagna di liceo che ora vive negli Usa, progressista, democratica e benestante, sia sconvolta dalla vittoria di Trump e ti sembra un po’ strana tutta questa meraviglia, visto che gli ultimi sondaggi, che prospettavano un testa a testa tra i due candidati, rendevano quantomeno verosimile la vittoria del biondissimo e bianchissimo palazzinaro.

Non è il mondo che sta impazzendo. E nemmeno tu. Probabilmente, è tutta colpa della filter bubble.

Il termine filter bubble è divenuto di pubblico dominio nel 2011, quando l’attivista internet Eli Pariser lo ha coniato per riferirsi al modo in cui i “motori di raccomandazioni” fanno scudo alle persone da certi aspetti del mondo reale.

Persone che ci piacciono + opinioni con cui siamo d’accordo

Pariser utilizzò l’esempio di due persone che googlano il termine “BP”. Uno ottiene link relativi alle notizie di investimento in merito a British Petroleum, mentre l’altro collegamenti relativi alla fuoriuscita di petrolio nel golfo del Messico. Questo accade, presumibilmente, a causa di qualche algoritmo di raccomandazione.

Un problema insidioso.

La ricerca sociale dimostra che le persone preferiscono ricevere informazioni con le quali sono d’accordo piuttosto che informazioni che sfidano le loro convinzioni. Questo problema è aggravato quando i social network raccomandano i contenuti in base a ciò che gli utenti hanno già dimostrato di gradire e a ciò che piace alle persone simili a loro.

Questa è la filter bubble: essere circondati solo da persone che ci piacciono e da contenuti con i quali siamo d’accordo.

Il vostro live stream di Facebook è l’esempio perfetto di una filter bubble.

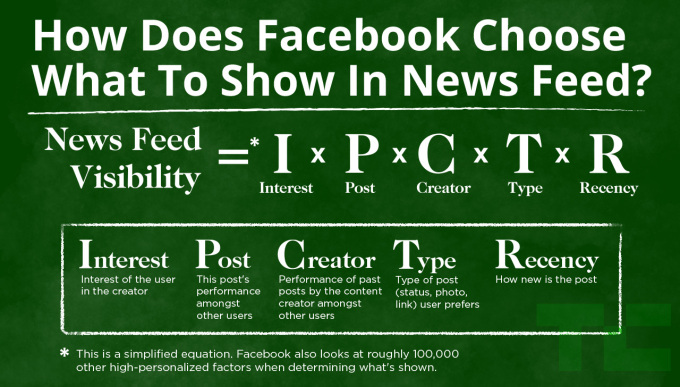

L’algoritmo infatti, è costruito sulla base di alcuni fattori misti: le nostre preferenze, i contenuti degli amici con cui abbiamo più interazioni, i contenuti simili a quelli che normalmente approfondiamo, etc. Nel corso del tempo, l’algoritmo affina la conoscenza dei nostri gusti e ci suggerisce contenuti con il più alto indice di gradimento possibile e supposto. E questo meccanismo è anche abbastanza semplice da percepire, basta prestare attenzione ai contenuti che vi vengono proposti ogni giorno, da un piccolo gruppo di pagine che visitate normalmente o da un ristretto gruppo di amici che seguite più assiduamente.

Com’è fatto l’algoritmo di Facebook (fonte: TechCrunch)

Nell’ottica di Facebook, questo meccanismo di recommendation rientra perfettamente nella sua mission: connetterci con le persone della nostra vita, che detto in altri termini suona come accedere a contenuti che ci interessano davvero.

Ovviamente, più preciso è l’algoritmo, più è facile per Facebook “inquadrare” ogni profilo in un gruppo di consumatori specifico in base ai gusti di ogni genere, alle preferenze politiche, di razza, credenze religiose, etc. etc.

Quest’inquadramento offre a Facebook la possibilità di aumentare la permanenza delle persone sulla piattaforma perché le fa accedere a contenuti che loro stessi ritengono interessanti da un lato, e dall’altro di poter offrire gli utenti così inquadrati agli inserzionisti, che programmano le loro campagne godendo di potentissimi strumenti di profilazione del pubblico.

Le nostre opinioni vengono confermate ad ogni nuovo post.

Quello che vediamo nella nostra filter bubble è un sistema che si compiace in un meccanismo di auto-conferma. Ci sono poche possibilità di uscire dalla nostra bolla, anche perché rispetto ai contenuti, Facebook non offre un vero e proprio sistema di ricerca.

L’alterità da noi stessi e dalle nostre preferenze svanisce ed ecco che si disegna un mondo di giustezza in cui le nostre opinioni sono le uniche ed imperanti.

Questa situazione comincia a suonare davvero grottesca e pericolosa nel momento in cui ragioniamo sul fatto che per circa il 50% dei suoi utenti, Facebook rappresenta una vera e propria fonte informativa, al pari della tv e dei giornali. Va considerato anche il fatto che le notizie che apprendiamo da Facebook spesso ci sono state raccomandate da persone a noi vicine e per questo godono di un altissimo livello di credibilità.

Quindi basta usare Facebook con più attenzione e imparare a prendere con le molle i contenuti che ci vengono proposti, direte voi. Purtroppo, è vero solo in parte.

Questo meccanismo di inclusione-esclusione dei contenuti non riguarda solo i Social Network, ma Google stessa, nel momento in cui i contenuti che ci vengono proposti – come sostiene Eli Pariser – soffrono anche essi di un meccanismo di raccomandazione.

I contenuti che mi vengono suggeriti sono personalizzati in base alle mie preferenze, alla mia localizzazione ed al gradimento che i miei contatti hanno dimostrato in precedenza per alcuni contenuti piuttosto che altri. Si potrebbe usare Google senza essere loggati, non consentendo la localizzazione, etc. Ok, ma in questo modo perdiamo anche il lato buono degli algoritmi di raccomandazione.

Tornando alle parole di Tim Berners-Lee, quella che si sta compiendo è una vera e propria frammentazione del web.

Nella nostra percezione il web è così come lo vediamo. Ma se quello che vedo io è influenzato pesantemente dalle mie interazioni e dai miei gusti, sarà necessariamente diverso da quello che vedi tu. Allora quale è il Web? Dobbiamo rinunciare all’idea più romantica e democratica di un unico “spazio informativo universale“? Siamo così limitati da non riuscire ad ammettere che esita altro da noi stessi?

Dobbiamo rinunciare ad un spazio informativo universale?

In quest’articolo, è riportata una ricerca svolta su un gruppo di profili Twitter intorno ad un argomento reattivo come l’aborto. I ricercatori hanno dimostrato che le persone, messe nelle condizioni di apprendere posizioni antitetiche alle loro, sono in grado di accoglierle, generare un dibattito positivo e risultare “arricchite” dalla conoscenza e dalla valutazione di opinioni opposte alle proprie.

Se rimaniamo chiusi nella nostra filter bubble e queste contaminazioni non avvengono, il pericolo più grande è che questa frammentazione possa polarizzare le popolazioni creando divisioni potenzialmente dannose nella società: fazioni ermetiche, destinate a non incrociarsi mai nella vita online, si incontrano nella realtà in momenti cruciali come all’indomani della più discussa campagna presidenziale statunitense e fanno fatica a riconoscersi, a percepire l’altra come reale, ad accettarne l’esistenza e le decisioni, soprattutto quando, come nel caso delle elezioni, le scelte operate dall’altra parte – quella che abbiamo considerato piccola, inconcludente, non reale – determinano il futuro di un’intera nazione.

Lasciarsi contaminare, del resto, sarà sempre la possibilità più affascinante che ci offre il World Wide Web.

Cos’è Threads

Cos’è Threads

Artifact, il TikTok per le notizie aiutato dall’intelligenza artificiale

Artifact, il TikTok per le notizie aiutato dall’intelligenza artificiale